Le app per generare varianti fantasiose delle nostre fotografie, accedono a database in rete che svelano le nostre mancanze culturali sui corpi: razzismo, grassofobia, abilismo.

Da alcuni anni faccio un grande sforzo sui social network per “abbassare il rumore della bellezza”, come la chiama Renee Engeln nel suo “Beauty Mania” edito da HarperCollins, ovvero cercare di ridurre il flusso costante e persistente di immagini stereotipate di corpi conformi. Lo faccio perché in passato ho avuto problemi psicologici nell’accettazione del mio corpo e nella percezione di esso; ancora oggi il mio percorso psicanalitico si concentra su questo tema e ho bisogno di preservare una zona sicura, una panic room in cui derubricare il valore che si dà alla bellezza estetica di almeno dieci tacche.

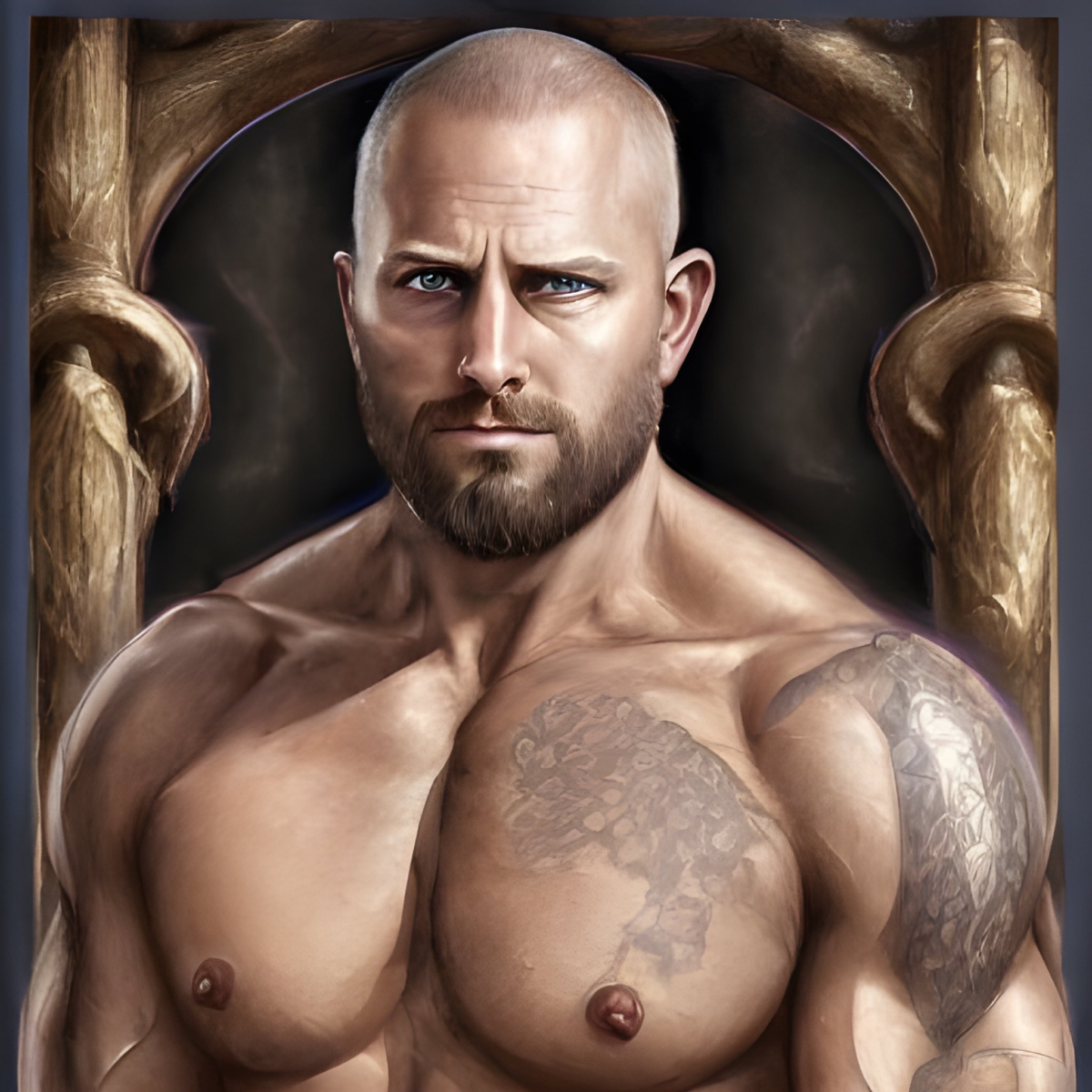

Difficile farlo quando a colazione, mentre sorseggi il caffè e guardi qualche social network, le prime (davvero, le primissime) immagini della giornata sono, nel mio caso, corpi di uomini muscolosi perfetti e sessualizzati: un monito costante su quale sia il metro della desiderabilità (ogni uomo gay conosce bene questa targettizzazione dell’algoritmo e sa di cosa sto parlando).

Chiariamoci, non che abbia deciso di bendarmi e affrontare quest’epoca digitale come una suora di clausura o un Edipo errante: il mio obiettivo è delimitare quel flusso a momenti designati e soprattutto decisi da me, in una fruizione attiva e consapevole (sì, leggila come masturbazione) e non tra le notizie del giorno, tra le pubblicità, tra le foto dei parenti, tra una recensione e l’altra di un videogioco, quando cerco una ricetta o quando cerco una pizzeria.

Fatta questa doverosa premessa, il campo in cui ho riflettuto in questi due giorni è proprio quello dei social network, Instagram in primis, con la novità dell’app LENSA che genera numerosi avatar attraverso un’intelligenza artificiale che ha invaso il feed mio e di tutti i miei conoscenti. Tolti i primi attimi di stupore per una tecnologia che da Midjourney in poi mi sta interessando molto, ho notato che tra i miei contatti qualcosa non tornava.

Un mio follower che abita nella provincia di Hong Kong registrava come nell’elaborazione della sua foto, i suoi avatar avessero un aspetto caucasico. E mentre l’onda del trend montava la sua potente risacca, altri account afrodiscendenti ne denunciavano le medesime modifiche: una pelle più chiara, a volte completamente bianca.

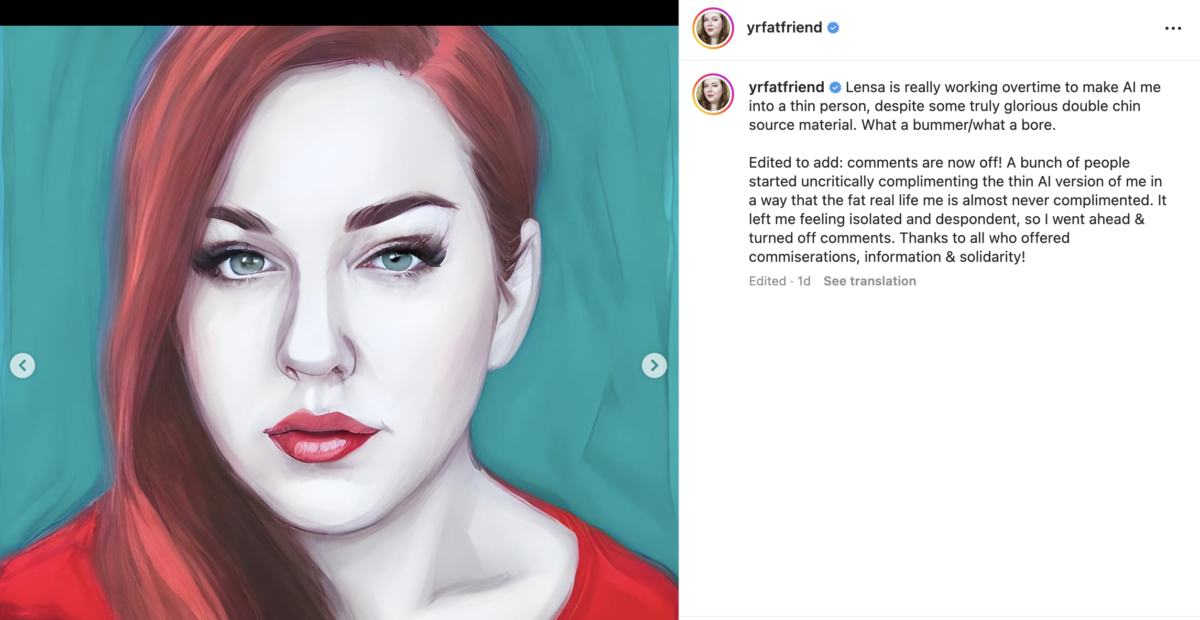

Alla scrittrice Aubrey Gordon viene tolto il doppio mento e il suo corpo grasso è costantemente dimagrito in tutte le proposte: “La AI di Lensa sta davvero facendo gli straordinari per trasformarmi in una persona magra. Che peccato/che noia”.

L’antropologa Giulia Paganelli nello stesso momento registra alcune flessioni del calcolo e così scrive: “Io ho caricate 20 foto cercando di diversificare inquadratura, momento del giorno (quindi luce), struttura dell’immagine perché non volevo dare alibi di mal comprensione sul mio corpo. Cosa ho scoperto? Che sono magra in tutti e 100 i ritratti che sono stati prodotti, qui una minima selezione. Potevo aspettarmelo? Certo, ma confrontandomi con altri esperimenti in cui corpi conformi o praticamente tali sono invece stati raffigurati come #corpigrassi non posso dire che questo mio corpo sia epurato dalla app – come lo sono, per esempio, corpi disabili o con dispositivi tecnologici a supporto. Cosa confonde l’AI? Ho capito che il mio viso ha una combo di caratteristiche e proporzione che per l’AI mi inseriscono nella categoria “bellezza” (occhi grandi, labbra carnose, naso a patata) e che questa automaticamente sancisca la forma del mio corpo”.

In questo momento in cui metto in fila le riflessioni degli ultimi due giorni, sempre più persone si accorgono che qualcosa in questa AI non va.

Marina Cuollo, scrittrice e attivista per le minoranze, scrive sulla sua pagina Instagram: “Per prima cosa l’AI ha associato al mio viso un corpo che non è mio, sulla base di una standardizzazione imparata in rete. La cosa più evidente però è che ha eliminato o rielaborato la mia tracheotomia. L’ha tolta dall’equazione perché non la capisce, non sa cos’è. La mancanza di rappresentazione di fatto rende le intelligenze artificiali incapaci di elaborare il mio corpo e molti altri corpi non conformi”.

Marina centra il punto, mentre vedo sempre più utenti di Instagram compiacersi per il proprio corpo incredibilmente nerboruto da supereroe per gli uomini ed estremamente voluttuoso per le donne, riproponendo associazioni semantiche del porno.

Quell’infinità di variazioni che l’AI prometteva con la sua grafica procedurale inizia a mostrare una realtà ben diversa: nessuna varietà, gli stereotipi son sempre gli stessi.

“Mi fa rabbia, perché è inevitabile che questo tipo di strumenti faranno parte del futuro del lavoro creativo, ma al momento non si sta facendo quasi nessun lavoro sui bias dei database raccolti da parte di chi sviluppa gli strumenti. ” mi viene in soccorso (as usual) l’illustratrice Roberta -Tostoini- Ragona.

“Né dal punto di vista dell’etica del lavoro creativo, non permettendo agli artisti di chiedere di non utilizzare il proprio lavoro per l’addestramento degli AI (in UK AOI si sta muovendo per chiedere che l’addestramento delle AI venga considerato come utilizzo di immagini derivate, quindi da compensare economicamente o da rimuovere dal database), né dal punto di vista dell’etica degli strumenti (è abbastanza evidente la differenza di trattamento vedendo come la stessa società si sta muovendo per quello che riguarda la musica).”

“Abeba Birhane parlando del proprio lavoro di ricerca sui bias ha rilevato non solo uno scenario inquietante, ma anche le conseguenze sulla propria salute mentale della continua esposizione alle immagini analizzate durante la ricerca.”

Roberta conclude: “Si sta portando il peggio che si poteva evitare in uno strumento prezioso, coi metodi del peggior capitalismo accelerazionista. E quando a fatica e con grande resistenza vengono messe delle pezze ai problemi più evidenti, una volta che hai abituato gli utenti all’idea che il lavoro e i corpi altrui sono una commodity è difficile far passare un altro tipo di messaggio.”

Si torna quindi al problema: LENSA (ma qualsiasi AI di elaborazione fotografica) attinge a database di foto digitali profondamente alterate dai nostri bias culturali.

Pozzi inquinati di una cultura di rappresentazione di corpi conformi, sempre uguali, che non attingono alle diversità perché le diversità non sono calcolate, sono negate, cancellate, forse in questo calcolo digitale siamo glitch.

Se un qualche legittimo timore sul futuro degli artisti fosse nato negli ultimi tempi, vedendo le illustrazioni paesaggistiche di Midjourney o i content automatizzati di 10consigli, il futuro ora mi pare molto più rassicurante:

la storia dell’arte è stata scritta da mostri, corpi politici e culturali sovversivi che hanno fatto evolvere linguaggi e coscienze, e in questa nuova eugenetica estetico-digitale i mostri sono stati completamente rimossi.

Il futuro dei corpi digitali non è in queste app.

L’AI non potrà mai evolvere alcunché (se non come strumento), lasciando il suo sterile calcolo a questo narcisistico auto-compiacimento, il tempo di una seduta al cesso; il tempo che impiegheremo per “abbassare il rumore della bellezza”.

Concludo con le sagge parole del prezioso fumettista Giulio Macaione: “Colleghi disegnatori, pensateci: una AI ci libera finalmente dalla rottura di coglioni del “me lo fai un ritratto?”.

Amen.

7cqnko

ubkxwy

5qwh7w

pbwqyy

6xinhp

02lq1j

6v6jd2